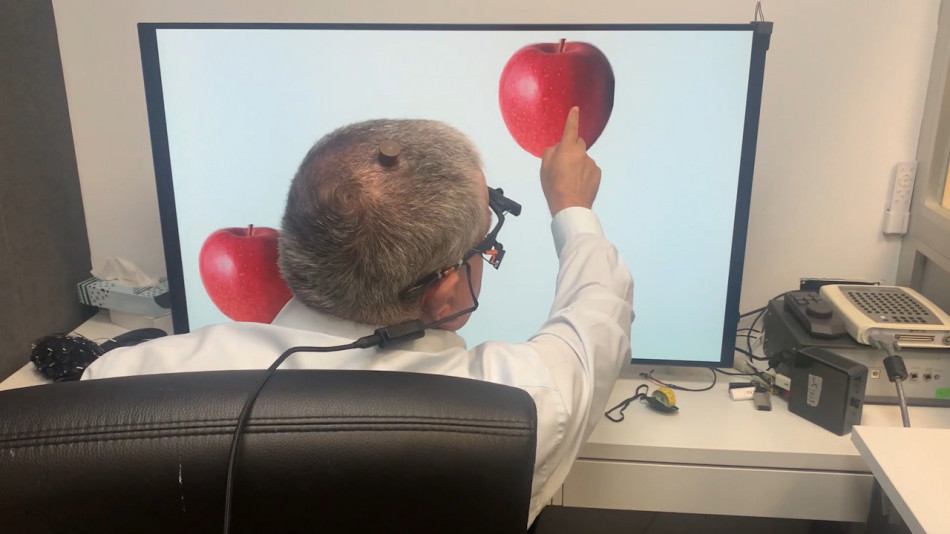

Великі мовні моделі, такі як ChatGPT, стали частіше помилятися навіть у найпростіших запитаннях внаслідок навчання на відгуках від користувачів. Це виявили науковці з Політехнічного університету Валенсії, проаналізувавши різні моделі штучного інтелекту. Як виявилося, у процесі навчання загальна точність таких моделей зростає, але вони дають неправильні відповіді замість утримання від відповіді, щоб «догодити» користувачам. Це підкреслює необхідність перевірки відповідей, отриманих від ШІ. Такі результати опублікували в журналі Nature.

Що вдалося з’ясувати про точність відповідей ШІ?

Автори дослідження проаналізували кілька сімейств великих мовних моделей, таких як чати GPT від OpenAI, моделі ШІ LLaMA від Meta та BLOOM від дослідників BigScience. Їх протестували на п’яти різних типах завдань: додаванні, анаграмах, питаннях з географії, наукових проблемах та перетворенні неструктурованої інформації.

Як виявилося, новіші моделі частіше давали неправильні відповіді замість уникання відповіді, вважали складними доволі прості для людини завдання та давали різні відповіді залежно від формулювання одного й того ж запитання. Оскільки люди часто користуються ШІ у сферах, у яких не мають достатньо компетенції, проблеми з наданням неправильних відповідей не вдалося компенсувати навіть людським наглядом.

Більше новин штучного інтелекту

💬 Завдяки своїй здатності швидко вишукувати необхідну інформацію та формулювати контраргументи, ChatGPT переконав прихильників різних теорій змови відмовитися від них.

🤖 А штучний інтелект YOLO виявив вразливість тесту CAPTCHA, який мав би відрізняти реальних користувачів від ботів, — сам ШІ зміг пройти його зі стовідсотковою точністю.

✍️ Допомогу від чат-ботів, на кшталт ChatGPT, високо оцінили учні шкіл, які до того мали проблеми з навчанням. ШІ допоміг їм краще зрозуміти складні теми та виконувати домашні завдання.

📖 А про те, чим може бути небезпечним штучний інтелект, який створює цифрові копії померлих, ми розповідали у матеріалі «Віртуальне воскресіння».