У досліді з геометричними задачами Платона дослідники помітили характерну рису роботи ChatGPT-4: замість того щоб одразу відтворити класичні розв’язки, штучний інтелект спершу імпровізував, помилявся та потребував підказок, що автори порівнюють із поведінкою учнів. Цю, на перший погляд, ваду вони змогли обернути на корисну особливість, що може допомогти у навчанні та засвоєнні нового матеріалу. Про експеримент Кембридзький університет повідомив у пресрелізі, а статтю опубліковано в International Journal of Mathematical Education in Science and Technology.

Що за задача Платона й чим вона зацікавила науковців?

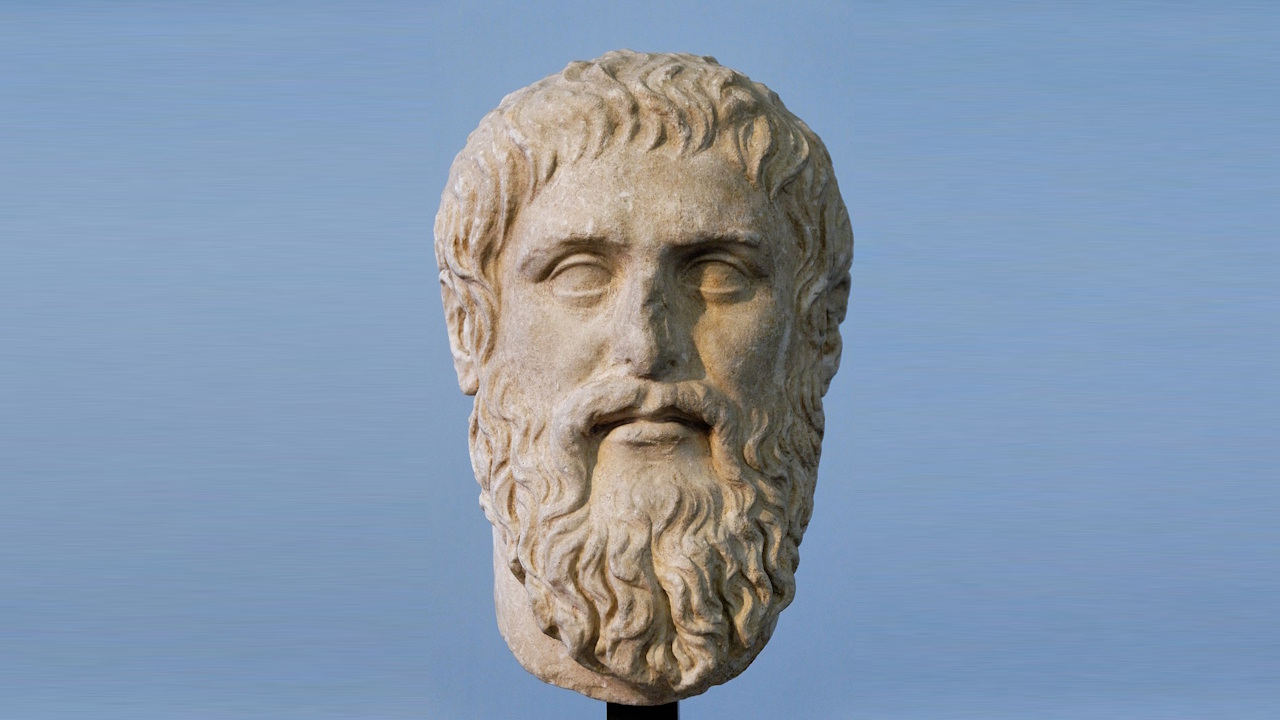

У «Меноні» Платон пропонує хлопцеві задачу: подвоїти площу квадрата. Інтуїтивна відповідь — подвоїти довжину сторони — хибна, бо площа тоді зростає вчетверо. Правильний хід — побудувати новий квадрат зі стороною, рівною діагоналі початкового; у такому разі площа збільшується рівно удвічі. Ця сцена століттями живить суперечку про походження знань: чи витягуємо ми їх з розуму чи творимо їх в процесі міркувань.

На тлі широкого використання великих мовних моделей постає практичне питання для освіти: чи ChatGPT просто відтворює відомі шаблони, чи здатен перемикатися між підходами під впливом запитань і обмежень викладача. Саме цей користувацький, педагогічний вимір і досліджували науковці Кембридзького університету: вони хотіли дізнатися, чи можна продуманими підказками змусити модель переключити траєкторію міркування на альтернативну і як це зробити.

Як проводили експеримент і що вийшло?

Надав Марко та Андреас Стіліанідіс ставили ChatGPT-4 запитання у стилі Платона, навмисно наштовхували на помилки й варіювали умови: після квадрата просили подвоїти площу трикутника та прямокутника зі збереженням пропорцій. Попри відомість платонівського розв’язку, модель послідовно стартувала з алгебри та лише після наполегливих сигналів про потребу «елегантного й точного» розв’язку подала геометричний варіант. На прямокутнику вона навіть помилково заявляла, що геометричного способу немає, а для трикутника знову зверталася до алгебри й лише з додатковими настановами переходила до коректної геометричної побудови. Самі автори застерігають: вони не аналізували внутрішню роботу моделі й описують лише спостережувану поведінку під час взаємодії, яка радше поєднувала відтворення наявних знань та імпровізаційне міркування під час діалогу.

Чому вивчення поведінки ШІ важливе для освіти?

Автори проводять паралель із «зоною найближчого розвитку»: між тим, що учень може зробити відразу, і тим, до чого доходить із підтримкою. З погляду машинного навчання це відповідає балансу між опорою на наявні знання та пошуком нових підходів (exploitation–exploration trade-off). Без додаткових вимог ChatGPT віддає перевагу явній алгебрі, та коли учитель накладає чіткі обмеження («без вимірювань», «тільки геометрична побудова», «поясни без формул»), це змінює хід міркування і спонукає модель спробувати інший шлях.

Для освіти це означає, що ChatGPT варто залучати не як джерело еталонних відповідей, а як співрозмовника для міркувань: ставити навідні запитання, просити альтернативні доведення, перевіряти точність. Водночас дослідники наголошують: на відміну від підручника, доведення від чатбота не можна приймати на віру — їх треба критично оцінювати, і саме ці навички варто закладати в навчальні програми.

Як поради штучного інтелекту вже стали частиною нашого життя

🧪 Хибні відповіді ChatGPT спричинили отруєння та психоз користувача, який протягом трьох місяців замість солі вживав токсичну сполуку.

🥗 На противагу цьому, у визначенні поживності продуктів штучний інтелект не поступився дієтологам, тож може допомогти людям, які стежать за своїм споживанням енергії.

🛸 А правдива інформація від чатбота допомогла конспірологам відмовитися від теорій змов.