Навіть розвинені моделі штучного інтелекту, здатні поєднувати зображення та текст, виявилися нездатними розуміти слово ні. Через це у них зросла кількість помилок, зокрема у визначенні діагнозів, адже вони не можуть розрізнити підписи «є симптоми» та «немає симптомів». І хоча тренування покращило їхню точність, воно не розв’язує проблему з нерозумінням штучним інтелектом самого принципу заперечення чогось. Статтю про це опублікували на сайті препринтів arXiv.

Що вказало на нездатність штучного інтелекту розуміти слово «ні»?

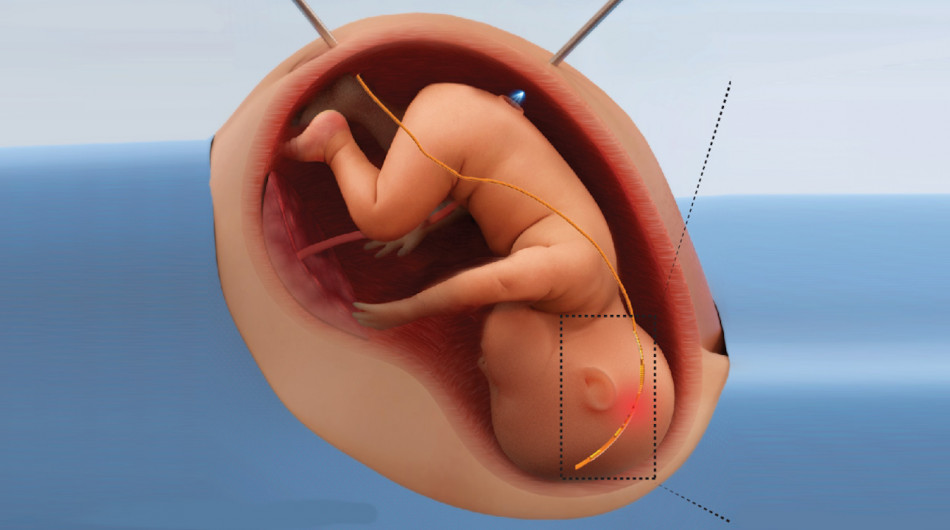

Дослідники аналізували 10 версій візуально-мовної моделі CLIP AI, розроблених різними людьми для пошуку деталей на зображеннях, і AIMV2, яка є однією з найновіших і найбільш просунутих візуально-мовних моделей. Серед досліджених моделей штучного інтелекту було дві, які створювали для аналізу медичних зображень і тренували саме на них. Для перевірки точності цих моделей розробили два тести. В одному потрібно було обрати зображення, яке містить предмет «А», але не предмет «Б». А в іншому — обрати для картинки найбільш відповідний підпис серед варіантів, які містили або ні слово «не».

Як виявилося, більшість моделей із точністю 80 відсотків відшукувала зображення, які містили предмет «А». Але коли їм вводили додаткове обмеження — щоб зображення не містили предмета «Б», — то їх точність падала до 65 відсотків. Потім науковці попросили натреновані на медичних зображеннях моделі обрати підпис до картинки з двох варіантів: є ознаки хвороби чи їх немає. Точність штучного інтелекту в такому випадку виявилася нижчою за 40 відсотків, що навіть менше за шанс випадкового вгадування.

З цього науковці зробили висновок, що штучний інтелект має позитивне упередження, тобто схильність сприймати всі речення як ствердні, що і зменшує його точність. Коли одну з моделей натренували розпізнавати картинки саме за підписами зі словом «не», то її точність у першому тесті зросла на 10 відсотків, а в другому — аж на 28. Однак цього недостатньо для використання штучного інтелекту як надійного інструмента для діагностики.

Які переваги й недоліки в штучного інтелекту

✍️ Проаналізувавши написані штучним інтелектом пояснення наукових статей, дослідники з’ясували, що вони мають більше надмірних спрощень і узагальнень, ніж написані людьми.

☹️ Крім цього, штучний інтелект виявився схильним частіше помилятися тоді, коли навчається на відгуках користувачів, адже намагається їм догодити.

🤓 Але великі мовні моделі на основі штучного інтелекту можуть бути корисними у суперечках з конспірологами, оскільки допомагають швидко шукати контраргументи.

🚦 Також штучний інтелект може допомогти перевіряти системи захисту сайтів від ботів, такі як тест CAPTCHA. Швейцарський штучний інтелект YOLO вже навчився цей захист обходити.