Роботи зараз як ніколи схожі на людей і справа не в їхній антропоморфності. Певною мірою можна сказати, що вони копіюють людські органи чуття: у них є слух, зір, нюх і навіть відчуття дотику та смаку. І саме сенсорні системи забезпечують “зв’язок” із реальністю і нам, і роботам. Ми розрізняємо кольори, насолоджуємося музикою та знаємо, скільки цукру додати у чай завдяки зоровій системі, моторній корі головного мозку, смаковим аналізаторам тощо. Наш мозок проводить величезну кількість операцій, щоб ми бачили світ таким, яким він є. Але навколишнє середовище нестатичне, тому недостатньо оперувати лише однією двомірною картинкою. Щоб сприймати світ в усій його глибині, необхідно уявляти відстань до об’єктів, їхню форму, розмір. Тому, наприклад, щоб навчити робота хоча б відрізняти людину від дерева, інженери щодня шукають нові способи подарувати їм зір. Тож як роботи сприймають наш світ та що їм для цього потрібно?

Краще один раз побачити. Як у роботів з’явився зір

Все ж найлегше оперувати тим, що бачиш. Одного погляду може бути достатньо, щоб визначити, куди ведуть сходи, чи шорстка поверхня стіни, як далеко щось знаходиться та в якому напрямку рухається. І для робота так само світ став би зрозумілішим, якби він міг побачити його нашими очима. Але людські очі не замінити двома камерами, які просто фіксуватимуть зображення.

Щоб роботи могли бачити те саме, що і ми, їх оснащують не тільки відеокамерами, а й ультразвуковими приладами, радарами, акустичними локаторами, лазерними і інфрачервоними сканерами. Звичайна тінь може сильно змінити відчуття простору та об’єму, тому необхідно багато сенсорів, які могли б пояснити, чи є перешкода дійсно перешкодою. Головні помилки штучного зору – сліпота, тобто неспрацьовування датчиків, і навпаки, помилкове спрацьовування – предмети-привиди, перепони, яких не існує.

Задача автономного робота швидко і точно визначити предмети навколо себе і на основі цього побудувати свою поведінку. Ідентифікація важлива: два мотоцикли схожі на один автомобіль, велосипедист на пішохода, а люди взагалі рухаються з довільною траєкторією. Так, робот знає, як оминути перешкоду, але щоб обрати найкращий варіант дій і уникнути аварій, необхідно визначати напрям, швидкість і передбачати рух об’єктів навколо. Загалом можна виділити такі основні види датчиків, які допомагають роботу бачити: камери, радари й лідари.

Бачити, як Термінатор

Камери для безпілотників – майже аналог людських очей: декілька камер фіксують зображення, а нейромережі визначають геометричні параметри об'єкта, шукають схожі ознаки у своїй пам'яті та ідентифікують його. Головне – створити велику бібліотеку прикладів. До речі, коли Google просить вас підтвердити, що ви не робот, і відмітити дорожні знаки або автобуси, він не знущається, а використовує вас, щоб навчати нейромережі розрізняти об'єкти дорожньої інфраструктури.

Дані з камер і датчиків системи автопілота автомобілів Tesla у погану погоду. greentheonly / YouTube

Звичайні цифрові 2D камери – найпопулярніший вибір: технологія недорога і їй немає рівних у визначенні того що знаходиться на дорозі. Завдяки високій роздільній здатності, камери краще за інших помічають світлофори, дорожню розмітку та навіть розуміють жести й можуть розпізнавати бійки у натовпі. Але зображення, яке отримують камери – це світло, перетворене в пікселі та цифрові дані. Тому важливою умовою є хороше освітлення: їм важко працювати вночі – світла від фар, наприклад, може не вистачити, а вдень тіні чи пересвіти сильно змінюють ландшафт.

Проте є й альтернатива – камери глибини. Вони отримують зображення, в кожному пікселі якого зберігається не колір, а відстань до об'єкта у визначеній точці, тому вони можуть працювати навіть у темряві. Найпростіший варіант цієї технології – камери Structured Light – структурованого світла. Загалом це виглядає так: на предмет, який потрібно ідентифікувати, за допомогою проєктора направляються зображення горизонтальних або вертикальних ліній, спотворення яких фіксує камера. І відповідно до цих спотворень робот оцінює форму, глибину та деталі об'єкта і перетворює їх на тривимірне зображення. Найперша масова камера глибини – безконтактний ігровий контролер для консолі Xbox 360 Microsoft Kinect працювала саме за таким принципом. Для геймерів Kinect втратив свій потенціал, але знайшов широке застосування серед інженерів: на його основі створили сенсорний екран на повітряній кульці, навчили дрон грати у пінг-понг та і сам Microsoft рік тому відродив технологію, але вже для створення інтелектуальних систем для бізнесу.

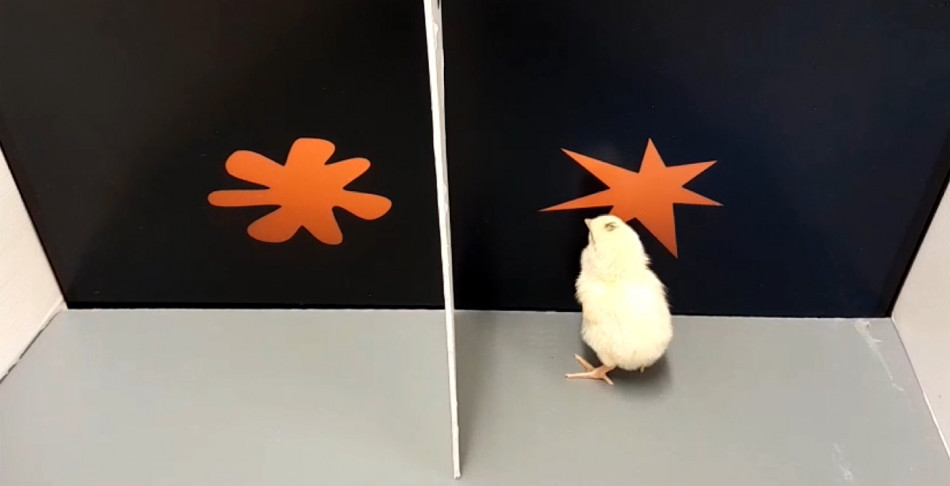

Для камер найважливішим аспектом є машинне навчання, адже бачити людину – одне, а відрізнити її від всього іншого – завдання складніше. Робот має впевнено орієнтуватись у морі піксельної інформації. На цьому етапі розвитку технологій обробка інформації з камер у режимі реального часу потребує великих обчислювальних потужностей, а багато деталей можуть залишитись непоміченими у тумані, за стіною зливи чи в зелені влітку.

Що камера не побачить, те радар почує

Але слабкі сторони камер – це сильні сторони радарів (і навпаки). Радіолокаційні датчики в режимі реального часу поширюють радіохвилі, які виявляють предмети та вимірюють до них відстань. Радари зазвичай виконують опорну роль – попереджають автономні системи, коли щось знаходиться поблизу і з якою швидкістю воно рухається. Головною перевагою радарів є те, що на них майже не впливають погодні умови та їм однаково на освітлення. Але вони мають низьку роздільну здатність, а отже не мають прямої можливості класифікувати перешкоду або оцінити її габарити, що сильно впливає на ймовірність помилки. Небагато радарних технологій можуть дозволити собі однаково добре оцінювати швидкість, відстань та положення об’єктів: якщо потрібно бачити всю ширину дороги, то доводиться жертвувати дальністю дії й навпаки.

Зображення з радару Navtech. NavtechRadar / YouTube

Переваги лишаються за лідарами?

Але поки звичайні камери не можуть працювати при поганому освітленні, комп’ютери ще не впевнені, що саме вони зустріли на шляху, а радарам складно оцінювати масштаби перешкод, всі ці проблеми легко вирішує LiDAR.

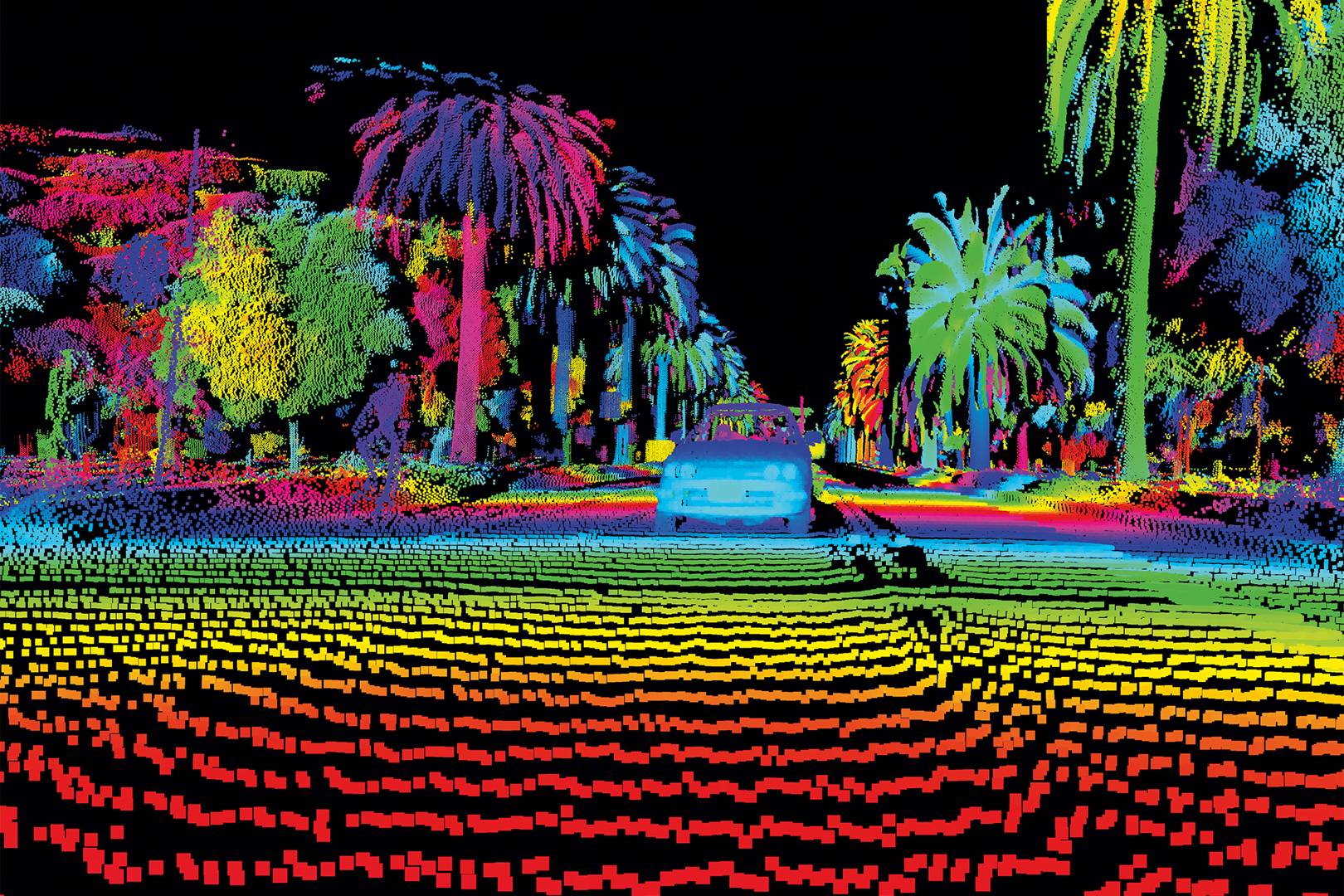

Абревіатура LiDAR розшифровується як «Light Identification Detection and Ranging», що дослівно – система світлової ідентифікації, виявлення та визначення дальності. Його ідея достатньо проста: щосекунди він запускає мільйони лазерних променів і вимірює, за який час вони, відбиваючись від поверхні, повертаються назад. Ці дані лідар використовує для побудови 3D-мапи, яка є детальнішою за ту, що пропонує радар, і простішою для розуміння комп'ютером, ніж зображення з 2D-камери. Погана погода вже перестала бути для лідарів великою проблемою – існують як алгоритми, які фільтрують “шуми”, так і лідари, здатні працювати в туман або дощ.

Лідар сьогодні – одна з невіддільних частин не лише безпілотних автомобілів, а й автономних роботів. Nauka.ua вже писала, як споряджені лідар-сенсорами роботи допоможуть шукати саморобні вибухові пристрої. Залежно від розміру і точності сенсора, лідар дозволяє вимірювати відстань, швидкість об’єктів, густину газу, температуру, будувати точні мапи лісів та рельєфу морського дна. Він може побачити дорожній знак за півкілометра, знайти давнє поселення Мая в Мексиці, а коли були пожежі в Австралії, за допомогою лідару отримали точні тривимірні карти складного ландшафту, що не дозволяє зробити, наприклад, аерофотознімання.

Сан-Франциско очами далекобійного лідара Ouster OS2-128. Ouster / YouTube

Навіщо лідар потрібен в iPhone?

Технологія лідарів широко застосовується в різних сферах життя, тож поява цієї функції в смартфонах була питанням часу. iPhone 12 Pro і 12 Pro Max стали першими смартфонами, в які вбудували лідар. Такий лідар навряд чи буде здатним знайти поселення Мая, проте, побудова 3D-моделей - задача спеціально для нього. Наприклад, можна створити точну 3D-модель кімнати та змінювати її дизайн у додатках відповідно до реальних масштабів. IPhone 12 Pro використовує лідар на своїй камері для підвищення якості фотографій: в залежності від відстані до об'єкта, змінюватимуться налаштування і знімки стануть більш чіткими та насиченими.

Проте, першим продуктом Apple з лідаром став останній iPad Pro, хоч там він виявився корисним лише для оцінки відстані до предметів. Але це був перший крок для розвитку доповненої реальності в портативних девайсах. До цього у смартфонах та планшетах використовували дещо схоже на лідар для кращої роботи FaceID - датчик глибини або Time-of-flight camera(ToF), оскільки тривимірне розпізнавання особи підвищує стабільність роботи сканера. За принципом лідарів, вона використовує відбите світло для вимірювання відстані до об’єктів, але вона спирається на один імпульс світла для відображення простору, тоді як лідар, використовує кілька точок світла, що є більш точним способом.

“Всі, хто покладається на лідар – приречені”. Як Ілон Маск оголосив війну лідарам

Поки лідарні датчики встановлюються вже і в iPhone, Ілон Маск – засновник компанії “Tesla”, вважає їх марнуванням часу і дуже дорогими “милицями”. Він впевнений, що для автономності авто четвертого рівня (з деякими обмеженнями) або п’ятого (повністю автоматичне водіння), буде достатньо візуального розпізнавання, тобто камер і дуже розумних нейромереж. (Рівні автономності безпілотників, де “0” рівень – це відсутня автоматизація, а “5” – керування людиною не потрібне). Чи має він рацію?

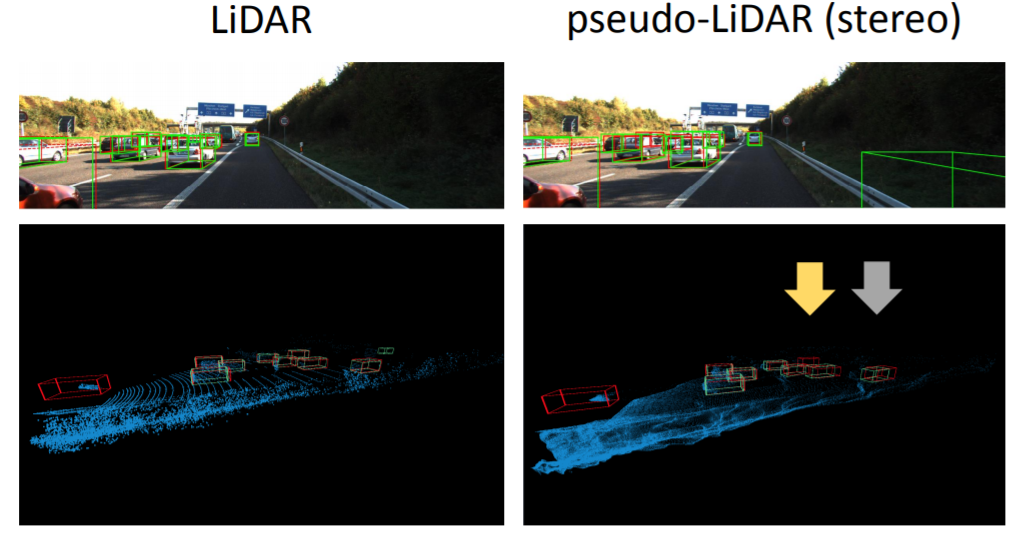

Певною мірою з думкою Ілона Маска можна погодитись, комп’ютерний зір здатен виконувати функції лідара. Дослідники з Корнелльського університету створили такий собі “псевдолідар” зі стереокамер та отримали не гірші результати. Вони перетворили пікселі з кожної стереокартинки у тривимірну точкову хмару – те саме, що і робить лідар, а потім обробили дані вже наявними алгоритмами. На популярній платформі для оцінки якості різних технологій комп’ютерного зору KITTI вони перевершили всі попередні результати: їхній алгоритм розпізнавав об’єкти у межах 30 метрів з точністю 74 %, хоча до цього найкращий результат на KITTI був 22 %.

Головний пункт критики позиції Маска – питання до безпеки. Лідар сьогодні вважається найбезпечнішою технологією для безпілотників, адже вони можуть бачити, що відбувається у “сліпих” зонах та можуть точно сказати, наскільки далеко знаходиться перешкода. Невчасне гальмування – одна з найпоширеніших причин ДТП. Але в той самий час є питання і до безпечності самого лідару: лазерне світло небезпечне для людських очей – промені паралельні й наше око фокусує їх всі в одному місці через що росте інтенсивність, а отже і загроза. Можна використовувати лідари з довжиною хвилі 1550 нанометрів, що безпечно для людського ока, але такі хвилі сильніше розсіюються в просторі та навіть можуть пошкодити техніку: на презентації у Лас-Вегасі лідар пошкодив камеру фотографу. Що саме сталось з камерою не з’ясували, але питання лишилось: чи будуть коректно працювати лідари на інших безпілотниках, коли їх стане більше на дорогах?

А от претензії Ілона до вартості лідарів вже не зовсім актуальні. Так, колись вартість сенсорів LiDAR Velodyne сягала 75 тисяч доларів, але зараз технології розвиваються, кількість стартапів збільшується і ціна падає. Наприклад, новий лідар від того ж гіганта ринку Velodyne вже можна буде придбати за 100 доларів. Та і розмір – ще одна причина невдоволень Маска, невеликий: п’ять на п’ять сантиметрів, хоча працюватиме він на відстанях до 100 метрів.

Бажання Tesla відмовитись від лідарів підтримує Nissan – вони використовуватимуть радари та камери, уникаючи лідарних або світлодіодних датчиків. Але натомість лідари від Luminar із Кремнієвої долини наближають Volvo до створення свого безпілотника, BMW уклали контракт з ізраїльською лідарною компанією Innoviz, а французька Valeo зареєструвала десятки замовлень вартістю 564 мільйони доларів на свої лідари. Існує багато сегментів, де можна застосовувати лідар – від безпілотників до розпізнавання обличчя. Так, лідар вже допомагає роботам самостійно проводити хімічні експерименти у лабораторіях, на його основі створюються навігаційні прилади для незрячих і разом з тим зараз розробляються нові покоління лідарів, здатних ігнорувати шуми і бачити на відстані до 45 кілометрів.

Чи можуть роботи відчувати?

Вода холодна, вітер західний, крісло м’яке, а у кишені лежить чотири монетки – щодня і щосекунди ми отримуємо величезну кількість інформації про світ просто торкаючись його кінчиками пальців. І техніка відчувати навчилась достатньо давно – наприклад, датчики температури й вологості активно використовуються в побуті. Але все ж це ще зарано називати тактильним відчуттям. У роботів немає кінестезії – здатності відчувати частини свого тіла в просторі, їм важко зрозуміти, як сильно потрібно тримати предмет, з якого боку його краще взяти і тим паче ідентифікувати його на дотик.

Почуття дотику здебільшого роботам замінюють датчики тиску, які вимірюють прикладену до них силу і перетворюють вплив в електронний сигнал. Але дотик це не просто значення сили, але і точне її положення, кут і вид взаємодії. Тому щоб відрізнити повну банку “Кока-Коли” від порожньої, електронній руці знадобилось 548 датчиків. І лише у трьох спробах з вісімдесяти, робот не зміг відрізнити кубик Рубіка від коробки з dvd-диском.

Загалом задачею таких роботів є позбавити людей рутинної чи небезпечної роботи й дати можливість робити щось складніше і цікавіше. Тож роботи потроху вчаться не руйнувати те, до чого торкаються (але і руйнувати також), навіть фіксують приємні для них дотики і допомагають піднімати предмети, повторюючи за вашими м’язами. А ще нещодавно ми писали про робота, який не підніматиме речі, вагу яких не зможе нести чи втримати.

Робот моніторить рухи м’язів інженера з MIT та бере участь у Bottle Cap Challenge. mit_csail / Instagram

Поряд з роботом тільки пошепки

Перетворивши наш голос на потік електронних сигналів ми навчили техніку чути – так винайшли телефон. Згодом вдалось навчити її слухати – 1962 року комп’ютер Shoebox від IBM розпізнавав 16 фраз і цифри від нуля до дев’яти. Сьогодні голосом можна викликати холодильник, вмикати кавоварку, керувати авто, вносити плани у календар – системи автоматичного розпізнавання мовлення еволюціонували в персональних асистентів.

Система автоматичного розпізнавання мовлення (ASR system) відрізняє ваші слова від інших звуків – фільтрує, а потрібні звукові хвилі перетворює в код – відцифровує. Отриману інформацію вона аналізує та запускає потрібний алгоритм дій, порівнюючи ваш запит з наявними у неї шаблонами. Штучний інтелект та нейронні мережі з кожним новим вашим запитом створюють нові моделі для порівняння і таким чином вдосконалюються. Але поки з Сірі немає порозуміння з півслова: вона може відповісти на ваше запитання якщо довкола не буде занадто шумно, а у вас не буде незрозумілого для неї акценту (іноді вона не розуміє навіть американців). Або навпаки, голосові помічники хибно спрацьовують і чують занадто багато, що навіть доводиться створювати додаткові насадки на розумні колонки, які відключають їм мікрофон.

Мета інженерів – не просто створення кальки з людського слуху, а рівень вище. Роботи вже можуть шукати зниклих людей за звуком, чути наше роздратування, сарказм або паніку і навіть, як ми вже писали, виявляти ознаки хвороби Альцгеймера на слух.

Цифровий нюх

Але не всі відчуття інженери намагаються скопіювати з людських: наприклад, вони надихаються слухом кажанів або дельфінів, що дозволить автономним роботам пересуватись в темряві, використовуючи для цього тільки ультразвуковий випромінювач і мікрофони – аналог ехолокації. І так само вчені, створюючи електронний ніс, орієнтуються не на людей, а на собак (і навіть плодових мух).

Відрізняти запахи роботів вчили з 1980-х, бо можливостей для застосування безліч: від пошуку вибухівок, виміру концентрації хімікатів в повітрі до створення крафтового пива і перевірки персиків на стиглість. Електронні носи можуть відрізняти до десяти різних запахів, а деякі навіть ідентифікувати запах людини, що знадобиться для пошукових операцій. Потенціал цієї технології значний: таких роботів можна буде використовувати для виявлення патологій дихальних шляхів чи патогенних мікроорганізмів, таких як сальмонела або кишкова паличка.

За розпізнавання запахів відповідає складна система взаємопов'язаних рецепторів і нейронів. Вони передають сигнали в мозок, який інтерпретує їх відповідно до наявних у нього шаблонів. Не буває спеціального рецептора для апельсина, але мозок відрізняє його від запаху яблука завдяки тому, що вже “чув” саме цю послідовність молекул та “записав” у свою картотеку. І електронний ніс працює так само: він складається з системи датчиків, які вловлюють визначені молекули, передають сигнал, а програма шукає потрібні шаблони.

Смак у роботів

З нюхом тісно пов’язаний смак. Спробуйте з’їсти льодяник закривши носа – він вже буде не таким яскраво ментоловим. Рецептори язика визначають смак, а нерви, розташовані в порожнині носа – запах. І якщо такі смаки, як солоний, гіркий, солодкий і кислий, мозок визначає без участі носа, то складніші, як-от смак стейку на грилі або стиглої вишні ми відчуваємо завдяки роботі нюхових і смакових рецепторів разом. Обидва відчуття передаються в мозок, який об'єднує інформацію і дозволяє насолоджуватись їжею.

Смак – річ не надто універсальна, різні люди опишуть смак одного і того самого тістечка по-різному: бісквіт може бути і перепеченим, і схожим на гуму, а текстура крему легкою, мов пушинка або такою, що тане у роті. Робота складно буде навчити використовувати такі порівняльні оцінки. І через це довгий час було досить складно “зацифрувати” смак їжі. Хоча саме завдяки цьому подібні сенсори повністю виключають можливість суб’єктивної оцінки. Так, можливо, скоро послуги сомельє не знадобляться: дослідники з Данії створили штучний язик, який і сам зможе підказати, який сорт вина краще обрати.

Сьогодні замість нас керують машиною, прибирають домівку та готують каву. Роботи замінюють людей на рутинній роботі й рахують замість нас витрачені калорії. Проте якщо все це, хоч і без задоволення, ми можемо робити самі, то працювати у відкритому космосі, досліджувати надра землі, вимірювати відстань з точністю до мікрона та ще багато чого, людина не зможе. Тому, щоб виконувати надзавдання, робот має отримувати точну інформацію про наш світ - відчувати його та швидко реагувати на будь-які зміни.